Deepfake(一种将人带入现有图像,音频记录或视频中,并用其他人的头像代替它们的媒体)变得越来越具有说服力。在2019年末,总部位于首尔的Hyperconnect的研究人员开发了一种工具(MarioNETte),该工具可以仅使用网络摄像头和静态图像来操纵历史人物,政客或CEO的面部特征。最近,来自香港科技巨头SenseTIme,南洋理工大学和中国科学院自动化研究所的一个团队提出了一个建议。一种通过获取音频序列以合成逼真的视频来编辑目标肖像素材的方法。与MarioNETte相反,SenseTime的技术是动态的,这意味着它可以更好地处理以前从未遇到过的媒体。尽管考虑到涉及深造的最新进展令人担忧,但结果令人印象深刻。

该研究的共同作者描述了该工作,指出“多对多”音频到视频翻译的任务(即,不具有源视频和目标视频的单一标识的翻译)是一项艰巨的任务。通常,只有很少数量的视频可用于训练AI系统,并且任何方法都必须应对受试者之间较大的音频视频变化以及对场景几何,材质,照明和动态的知识缺乏。

为了克服这些挑战,团队的方法使用表情参数空间或与训练开始之前设置的面部特征相关的值作为音频到视频映射的目标空间。他们说,这有助于系统比全像素更有效地学习映射,因为表达式在语义上与音频源更相关,并且可以通过机器学习算法生成参数来进行操作。

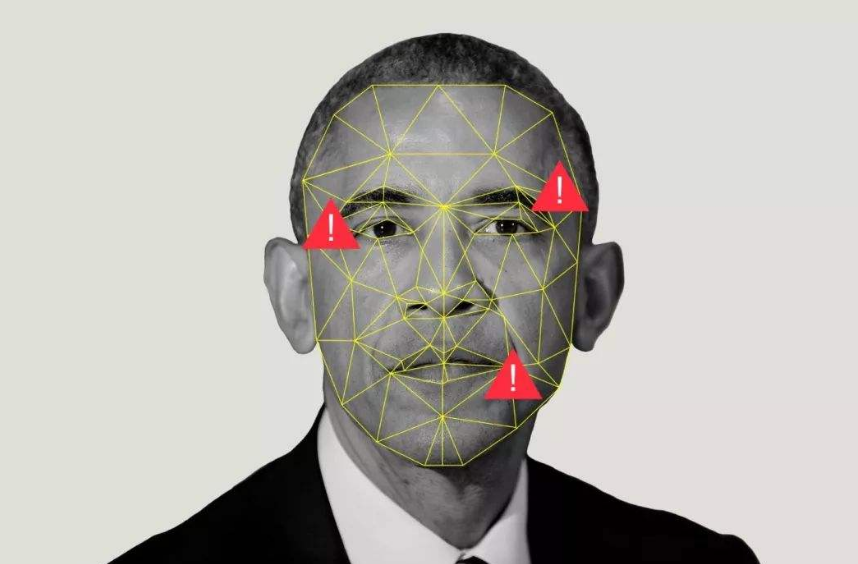

在研究人员的框架中,生成的表情参数(与目标对象的几何和姿势参数结合)为三维面部网格的重建提供了相同的身份和头部姿势,但嘴唇运动与源音频音素相匹配(声音上在感知上截然不同的单位)。一个专门的组件使音频到表达的翻译与源音频的身份无关,从而使翻译对于不同的人和源音频的声音变化具有鲁棒性。然后系统从人的嘴巴区域提取特征(地标)以确保精确地映射每个动作,首先将其表示为热图,然后将热图与源视频中的帧合并,将热图和帧作为输入以完成嘴巴区域。

研究人员说,在一项要求100名志愿者评估168个视频剪辑的真实性的研究中,其中一半是由系统合成的,合成视频的55%的时间被标记为“真实”,而90%的时间标记为“真实”。基本事实。他们将此归因于其系统捕获牙齿和面部纹理细节的出色能力,以及嘴角和鼻唇沟等特征(嘴两侧的压痕线从鼻子边缘延伸到嘴的外角)。 。

研究人员承认,他们的系统可能出于“各种恶意目的”而被滥用或滥用,例如媒体操纵或“散布恶意宣传”。作为补救措施,他们建议采取“保护措施”以及颁布和执行授权编辑视频的立法。被这样标记。他们写道:“在开发创意和创新技术的最前沿,我们努力开发方法来检测编辑的视频,作为对策。” “我们还鼓励公众充当哨兵向[当局]报告任何看似可疑的视频。共同努力,我们将能够在不损害公众个人利益的情况下推广尖端和创新技术。”

不幸的是,这些提议似乎不太可能阻止像上面描述的那样由AI产生的深层造假。总部位于阿姆斯特丹的网络安全创业公司Deeptrace在6月和7月的最新统计中发现了14698个互联网上的Deepfake视频,高于去年12月的7964个,在短短七个月内增长了84%。令人不安的不仅是因为深造假货可能会在选举中被用来影响公众舆论,或者将某人卷入他们未曾犯下的罪行中,而且还因为该技术已经产生了色情材料 并使 数以百万计的公司陷于瘫痪美元。

为了对抗深造的传播,Facebook –以及Amazon Web Services(AWS),微软,人工智能合作伙伴关系以及康奈尔科技大学的学者;麻省理工学院 牛津大学 加州大学伯克利分校 马里兰大学学院公园分校; 和纽约州立大学奥尔巴尼分校—共同领导了9月宣布的Deepfake检测挑战赛。该挑战于12月启动,是在与Google内部技术孵化器Jigsaw合作生产的大型可视化深层假冒发布之后,该软件包被并入了基准,可供研究人员免费用于合成视频检测系统开发。在今年早些时候,Google公开了一系列语音数据 包含公司的文本语音转换模型说出的短语,作为AVspoof 2019竞赛的一部分,以开发可以区分真实语音和计算机生成语音的系统。

伴随着这些努力,Facebook,Twitter和其他在线平台已承诺实施有关处理AI操纵的媒体的新规则。