欧盟准备禁止用于大规模监视或社会行为排名的人工智能系统,而开发AI的公司如果不遵守管理软件应用程序的新规则,将面临高达全球收入4%的罚款。

根据彭博社获得的提案草案,这些规则是欧盟执行机构欧洲委员会将提议的立法的一部分。在委员会宣布这项措施之前,细节可能会有所变化,预计最快将在下周公布。

欧盟提案预计将包括以下规则:

欧盟将禁止用于操纵人类行为,利用有关个人或个人群体的信息,用于进行社会评分或不加区分的监视的AI系统。一些公共安全例外将适用。

在公共场所使用的远程生物识别系统(例如面部识别)将需要获得当局的特别授权。

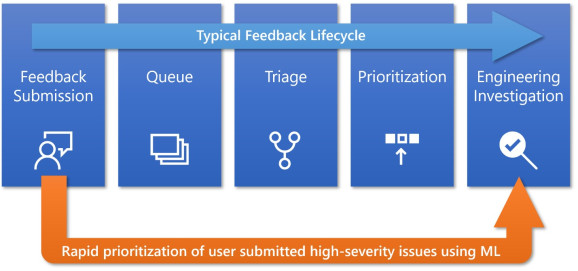

被认为是“高风险”的AI应用程序必须在部署之前进行检查,以确保以可追溯的方式并在人工监督下对系统进行无偏数据集的培训。

高风险的AI将涉及可能危害人们安全,生命或基本权利的系统,以及涉及欧盟的民主进程的系统,例如无人驾驶汽车和远程手术等。

一些公司将被允许自己进行评估,而另一些公司将受到第三方的检查。评估机构颁发的合规证书有效期最长为五年。

规则将同样适用于位于欧盟或国外的公司。

根据该文件,将要求欧洲成员国任命评估机构对系统进行测试,认证和检查。开发禁止的AI服务,提供不正确的信息或未能与国家主管部门合作的公司可能会被处以最高全球收入的4%的罚款。

该文件称,这些规则不适用于专门用于军事目的的人工智能系统。

欧盟发言人拒绝对拟议的规则发表评论。Politico早些时候对文件草案进行了报告。